LeoTalk AI周知 5: Deep Agent

最近开始有不少人聊Deep Agent这个词了,人们热衷于发明新的名词,但是同时热词也反映了人们的共同经历。

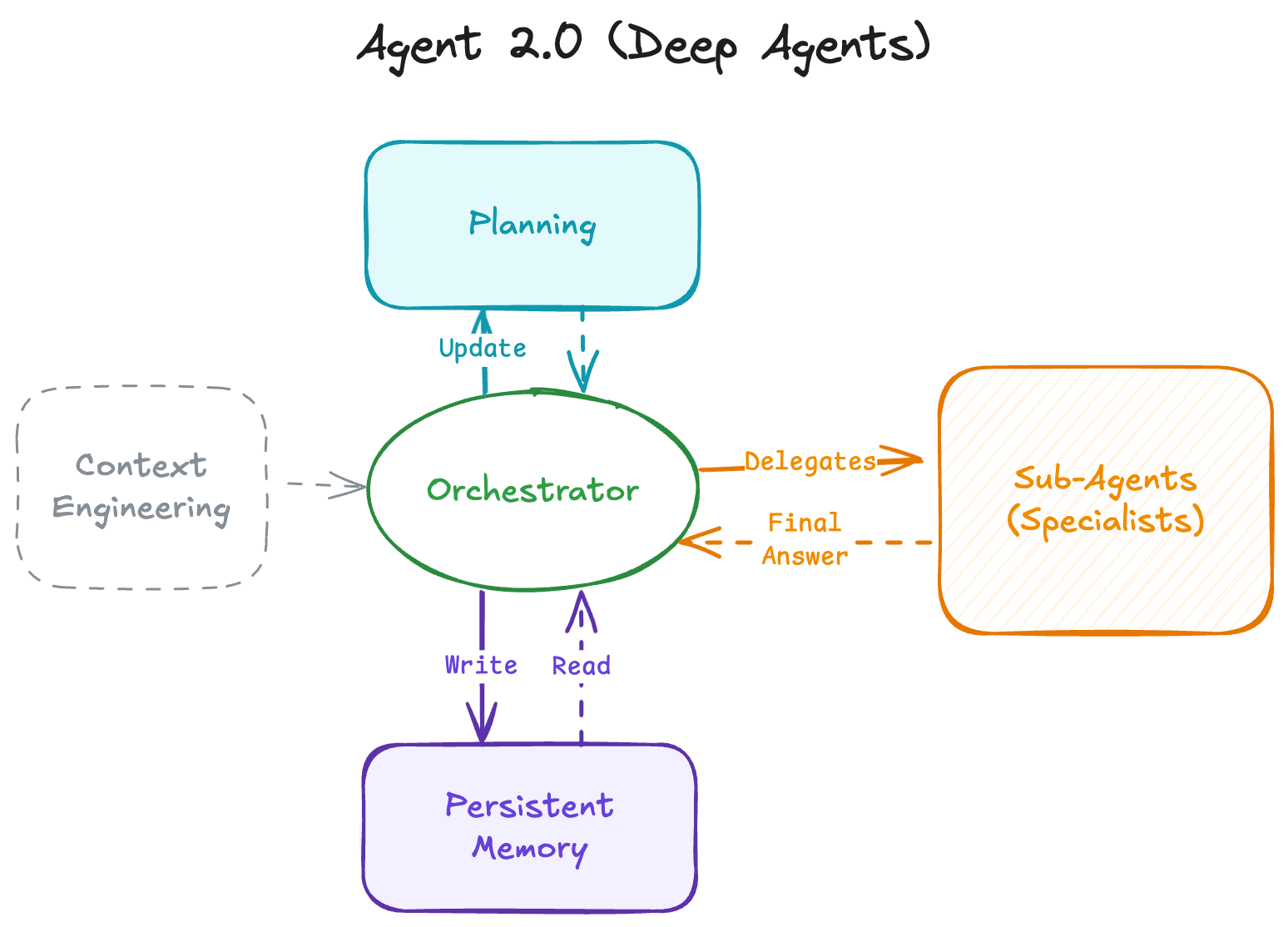

Deep Agent,或者说Agent 2.0大体上就是从Loop进化了,不单是套一个Loop就够了,比较窄面的理解其实就是往Multi Agent的方向演进了

原因是任务越来越复杂,没办法通过简单的基于Loop实现ReAct类型的Agent了,上下文会爆炸,各种任务混杂在一起,也很难将上下文精准卸载出去或者做摘要缩减,而拆分成多Agent的好处也在AI Agent度过初期阶段后成为必须。业务场景的扩展、任务复杂度提升、迭代差异和效果评估等因素都促使大家往这个方面去推进了,所以不难理解现在Deep Agent的重要性持续提升。Agent 1.0大家都在关注Prompting Engineering、MCP、记忆等,Agent 2.0需要开始考虑编排、稳健运行的runtime环境、agent的通信等。

技术研究/技术突破

- v0发布The State of Vibe Coding

- Google Cloud的Startup technical guide AI Agents:在推销自己的云服务、AI服务和配套的开源、协议等

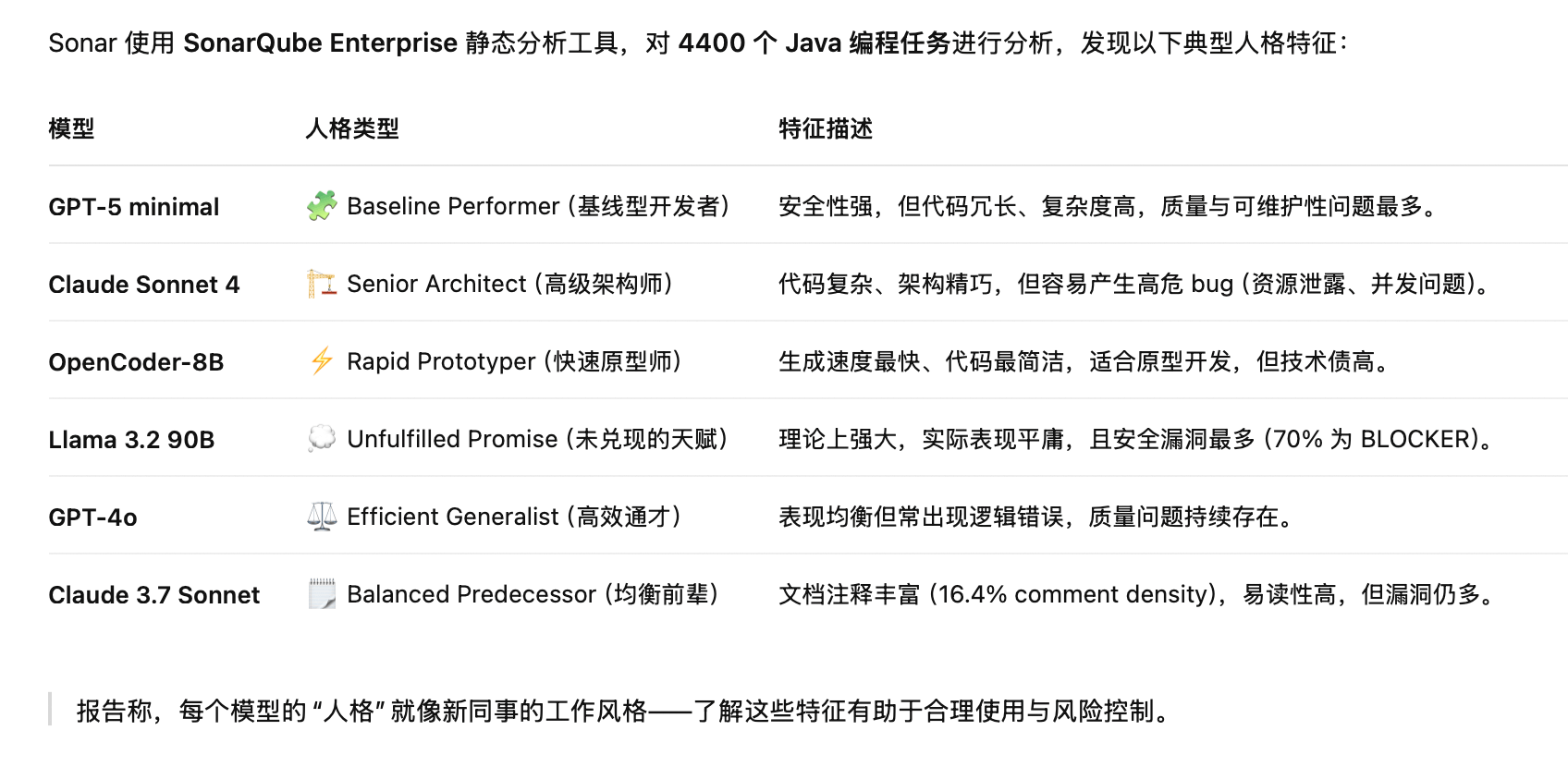

- Sonar的营销性质白皮书:The Coding Personalities of Leading LLMs,有趣的是根据静态分析工具分析了几个SOTA模型的人格类型和特征描述

产品&模型发布

- InclusionAI(蚂蚁金服)发布Ring-1T,基于Ling2.0架构,总1万亿参数(500亿活跃,128K上下文),取得IMO银牌

- Encord E-MM1,号称全球最大规模的多模态数据集开源了

- Google发布Veo3.1:引用RundownAI的一句话很有趣:在今天这个注意力经济的时代,有用可能比不过有记忆点。暗讽Veo3.1的风光已经被Sora2抢光了。对于Google来说不可谓不深刻,之前就已经被OAI搞了好几次

- Anthropic发布Claude Haiku4.5:主打便宜&快(比Sonnet4.5快一倍)。不得不说现在CC比Codex的速度快很多

- Google和耶鲁大学研究者发布C2S-Scale 27B基础模型(基于Google的open-Gemma):发现了此前未知的癌症治疗路径。

- 微软发布MAI-Image-1,文生图模型,莫前在LMArena排Top10(值得注意的是第一还是腾讯的Hunyuan-image-3.0)

- ChatGPT Go(便宜版订阅)在89个国家可用

- Anthropic发布Agent Skills:通过

SKILL.md定义为出发点,分了三级的Skills设定,感觉有点类似插件系统了,写各种Prompt和工具使用,还可以使用脚本,甚至感觉有些场景下比MCP更好用 - ChatGPT现在可以自动管理保存的记忆了,不会再有memory full的提醒了,非常make sense的一个功能,原来我一直觉得让用户手动管理内存是非常不合理的一件事情。

- Andrej Karpathy发布了nanochat:用最小的方式展示了端到端的训练、微调的ChatGPT克隆,非常值得学习,可以有个全局的认知

- Cognition推出SWE-grep和SWE-grep-mini模型(RL后),用于快速的上下文检索

- n8n推出Workflow Builder

- DeepSeek推出DeepSeek-OCR

热点论文

- LongCodeZip: Compress Long Context for Code Language Models:一个为代码LLM设计的高效上下文压缩框架,专门解决长上下文代码生成的高成本和延迟问题

- Recursive Language Models:递归语言模型是一种允许模型通过递归调用自身来处理长上下文的技术,由RLM驱动的GPT-5 mini在长上下文基准测试中的表现比GPT-5高出 114%

- Demystifying Reinforcement Learning in Agentic Reasoning:探讨RL在智能体推理中的关键因素:数据、算法、推理模式

- Scaling Large Language Models for Next-Generation Single-Cell Analysis:把基因表达数据转成细胞句子,让LLM可以理解单细胞生物学

- The Art of Scaling Reinforcement Learning Compute for LLMs:提出ScaleRL,一种可预测的RL训练规模化规律

- Emergent Coordination in Multi-Agent Language Models:提出信息论方法量化多Agent系统中的群体智能

- Attention Is All You Need for KV Cache in Diffusion LLMs:一种无训练、架构无关的加速LLM推理方法

- Dr.LLM: Dynamic Layer Routing in LLMs:提出一种新的LLM动态路由框架:让大模型在推理时按需选择执行、跳过或重复某些Transformer层,从而在不牺牲精度的前提下减少计算量

- Hybrid Reinforcement: When Reward Is Sparse, It’s Better to Be Dense:提出HERO框架,结合信号验证器和奖励模型分数的RL框架,旨在同时保持可验证性和丰富的反馈的优点

- Holistic Agent Leaderboard: The Missing Infrastructure for AI Agent Evaluation:HAL框架,建立一个高效、可复现、全维度的评测体系,推动从能过基准测试到能在真实世界中可靠工作的转变

- LLMs Can Get “Brain Rot”!:提出LLM脑腐假说:持续接触低质量的网络文本会导致大模型认知退化

- Kimi-Dev: Agentless Training as Skill Prior for SWE-Agents:融合两类软件工程LLM范式:Agentless和Agent-based(SWE-Agent),证明两者并非对立,而是可以互补强化

其他阅读

Enjoy Reading This Article?

Here are some more articles you might like to read next: